Même si la discipline du SEO évolue constamment, il n’en demeure pas moins que les bases techniques demeurent aussi importantes maintenant, surtout lorsque l’on parle de maximiser l’accessibilité et l’indexation des contenus d’un site Internet.

Tout spécialiste SEO comprend l’importance de faciliter le travail des robots d’indexation. C’est d’ailleurs pour cette raison que le protocole Sitemap existe, car il permet à un webmestre d’informer les moteurs de recherches quelles pages d’un site web sont disponibles pour indexation.

Il faut cependant faire attention. Si un fichier Sitemap dûment optimisé favorise l’exploration de vos contenus, il faut savoir que la situation renversée s’applique également : un fichier Sitemap bourré d’erreur compliquera l’indexation des contenus, et incitera les robots d’indexation à vous accorder moins d’attention, par exemple en espaçant leurs visites sur votre site.

Aujourd’hui dans ce 12e article de la série astuces SEO, nous découvrirons une méthode très simple pour diagnostiquer la qualité de notre fichier Sitemap.xml, et assurer ainsi que nous ne mettons pas de bâton dans les roues des robots d’indexation.

À quoi sert le fichier Sitemap.xml ?

Le fichier Sitemap.xml a comme mission de répertorier les pages d’un site Internet, et fournir aux robots d’indexations des informations sur la structure du site. Simplement dits, les robots d’indexation consultent ce fichier pour explorer un site de façon optimale et intelligente.

Le fichier Sitemap.xml est généralement déposé à la racine du site, lequel peut être inclus dans le fichier robots.txt pour faciliter son accès. Il est également conseillé de le soumettre directement à Google à travers la plateforme Search Console.

Les dangers d’un fichier Sitemap.xml malpropre

Aussi utile peut être le sitemap pour le référencement de vos pages internes, il faut tout de même assurer que les adresses incluent dans le sitemap sont valides et accessibles.

Une erreur très fréquente est justement celle où un fichier Sitemap.xml est jugé « malpropre », lorsque celui-ci contient des URL brisées (404) et/ou redirigées (301/302).

Il faut savoir que les moteurs de recherche détestent travailler avec des fichiers Sitemap.xml malpropres. Dans une interview datant de quelques années, un haut responsable du search chez Bing Duane Forrester mentionnait durant une interview le très faible taux de tolérance de Bing pour les fichiers Sitemap.xml contenant des erreurs :

« Your Sitemaps need to be clean. We have a 1% allowance for dirt in a Sitemap. If we see more than a 1% level of dirt, we begin losing trust in the Sitemap. »

Pourquoi donc risquer de perdre la confiance des robots d’indexation?

Astuce SEO : Valider la qualité de votre sitemap.xml

Rentrons maintenant dans le vif du sujet. Voici la procédure à suivre pour diagnostiquer la qualité de votre fichier Sitemap.xml et identifier toutes URL problématiques.

Étape #1 : Sauvegarder votre fichier Sitemap.xml en local

Le fichier Sitemap.xml étant hébergé sur le serveur, vous devez le télécharger en local pour pouvoir l’analyser. On demande donc au responsable de vous le transmettre, ou encore on le télécharge directement à partir du site.

Habituellement, un simple « enregistrer sous » à partir de votre fureteur à l’URL du fichier sitemap (votresite.com/sitemap.xml) permettra d’enregistrer le fichier directement sur votre ordinateur.

Étape #2 : Extraire les URL du sitemap.xml

Une fois le fichier en mode local, on ouvre celui-ci directement dans le logiciel de votre choix (exemple Microsoft Word et/ou Excel), afin de pouvoir copier la liste des URL contenues dans le sitemap.xml.

L’objectif ici est d’extraire les URL du sitemap, lesquelles nous exploreront à la prochaine étape.

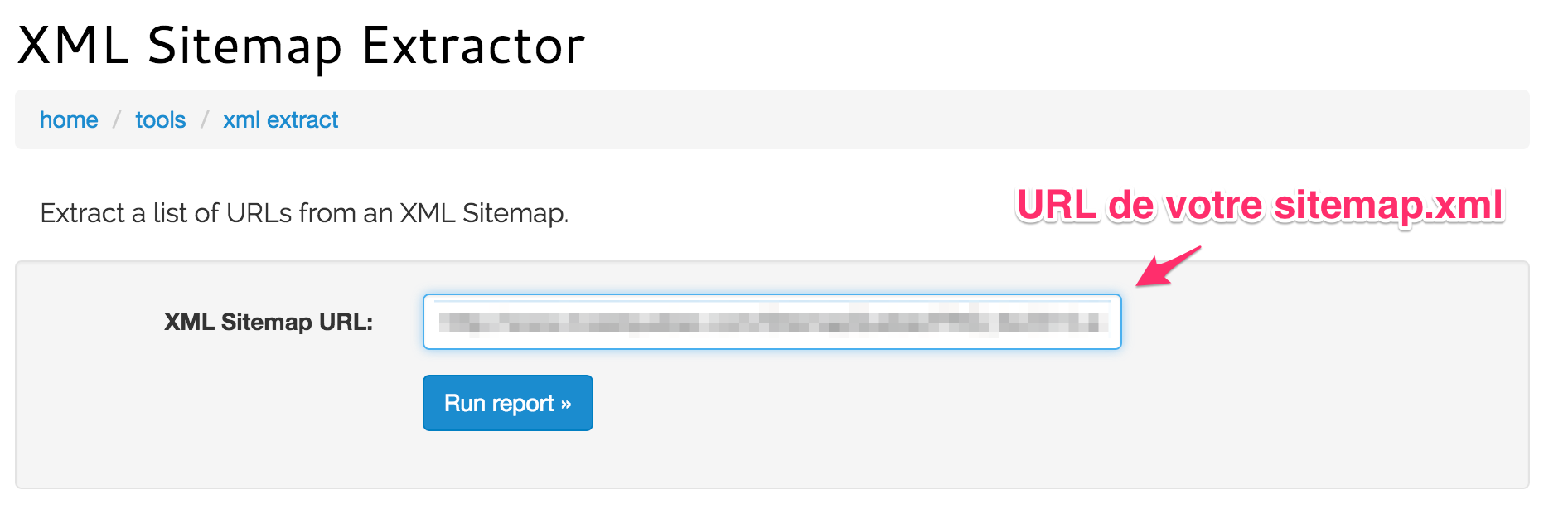

Un outil qui très utile pour extraire les URL d’un sitemap.xml est ce script très bien pensé de Rob Hammond. Vous n’avez qu’à simplement entrer l’URL de votre sitemap.xml dans la boite du script, et celui-ci vous sortira la liste des URL en bonne et due forme :

Après avoir cliqué sur “Run Report”, l’outil générera une liste des URL comprises dans le sitemap.xml:

On copie les deux colonnes dans Excel, on supprime la première contenant les rangs d’URL numérotés, et on conserve uniquement la colonne comprenant la liste des adresses.

Étape #3 : Scanner les URL avec votre outil de crawl

Maintenant que vous avez la liste des URL comprises dans votre sitemap et dans un format facile à manipuler, la troisième étape consiste à passer ces mêmes URL dans un outil de crawl, tel que Screaming Frog.

Notre objectif: trouver toutes les URL dont la réponse est autre que 200 (Ok), par exemple des 404 (Introuvables), erreurs de serveur (5XX) (et/ou des redirections temporaires (302) ou permanentes (301).

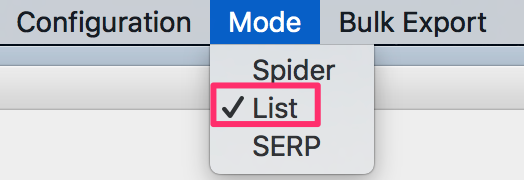

Dans Screaming Frog, j’active l’option « List » dans le mode d’exploration, ce qui me permet d’entrer une liste d’URL manuellement.

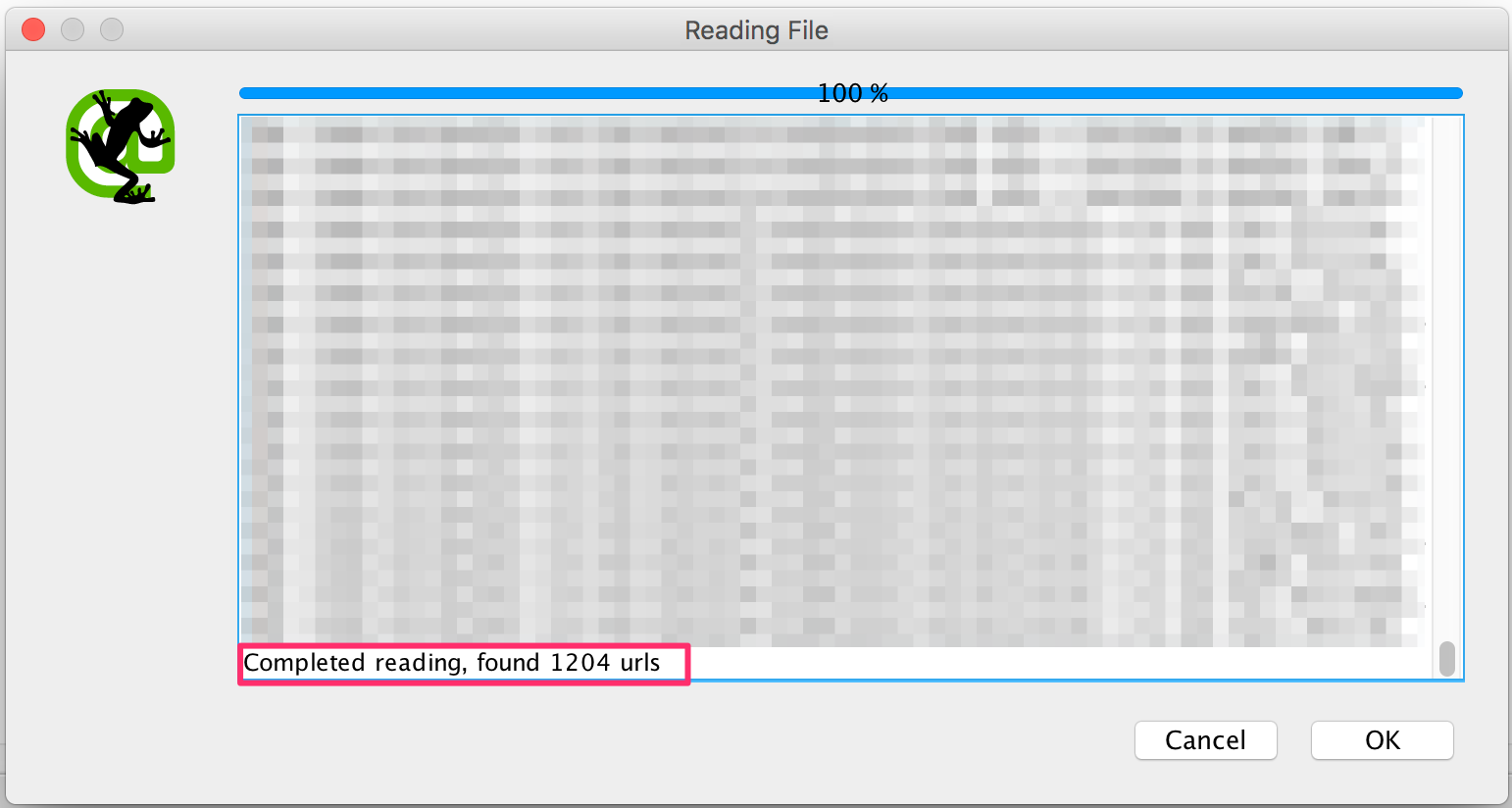

Les URL entrées dans l’outil d’exploration, on peut maintenant lancer le crawl avec “Ok”.

Étape #4 : Repérez les URL problématiques…et faire le ménage

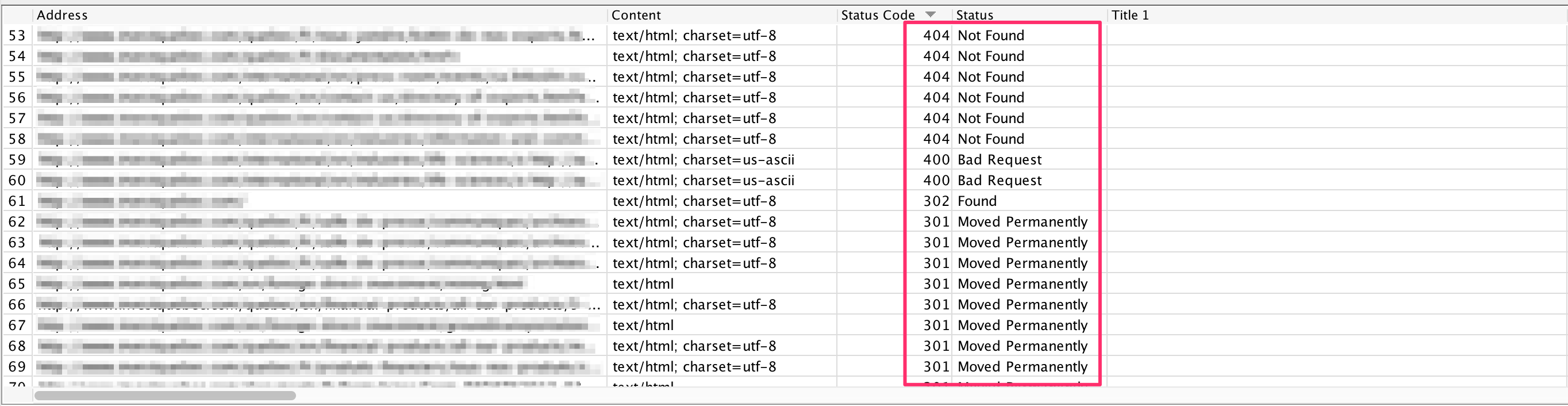

Une fois le crawl des URL terminé, il est temps d’analyser l’étendue des dégâts :

Tel que démontré dans l’exemple ci-haut, Screaming Frog nous retourne une liste considérable d’URL soit brisées (404), ou redirigées vers une autre destination (301 et 302). Cela signifie que le sitemap.xml contient des pages qui ne peuvent être indexées par Google, ou encore qui ne sont plus d’actualité.

Il s’agit d’un bon exemple de gaspillage de ressources. En tant que gestionnaire de site Internet, nos propriétés numériques ont toutes un certain niveau d’attention que Google nous accorde, qui augmente ou diminue selon la qualité ainsi que la popularité du site en question.

En fournissant un fichier Sitemap rempli d’erreurs ou d’URL impertinentes, on alourdit la tâche du robot d’indexation qui doit démêler les bonnes des mauvaises adresses.

Ce n’est pas évidemment une situation qui aidera à développer la confiance des moteurs envers votre site.

Conclusion : Ne pas hésiter à répéter l’expérience

Bien sûr, les sitemap.xml sont constamment mis à jour, par exemple dans le cas où vous ajoutez et/ou modifiez des contenus sur votre site. Cela signifie qu’il est une bonne pratique de scanner régulièrement votre sitemap.xml pour voir si de nouvelles erreurs y sont glissées.

En espérant que l’astuce SEO du jour vous a plu. Bonne optimisation !