Nous avons souvent tendance à l’oublier, mais avant même de penser aux stratégies de trafic et de liens entrants, notre priorité à titre de stratège SEO est d’assurer que les pages de notre site soient indexées par Google. En effet, nous avons souvent le réflexe de concentrer notre attention sur les stratégies de contenus et de liens entrants, et cela dans l’optique de générer du trafic le plus rapidement possible. Pourtant, nos efforts resteront vains si, fautes d’êtres indexées, nos pages demeurent introuvables pour les requêtes les concernant.

Tout spécialiste SEO possède sa propre technique de vérifier l’état de l’indexation d’un site. La plus populaire présentement est probablement à travers la plateforme Google Webmaster Tools, où l’on peut soumettre un fichier sitemap et constater par la suite si des erreurs d’indexation sont survenues. Cependant, cette méthode n’est pas entièrement fiable, car l’absence de toutes erreurs ne vient pas automatiquement signifier que les URL sont belles et bien indexées.

Aujourd’hui dans ce nouvel article un peu “old school” et portant sur la série des astuces SEO, nous analyserons ensemble comment vérifier si les pages de notre site sont indexées, et sinon, lesquelles sont manquantes.

Étape 1 : Préparer une liste de vos URL et les importer dans un fichier Excel

Afin de mener à bien cette stratégie, nous devons passer à travers trois étapes :

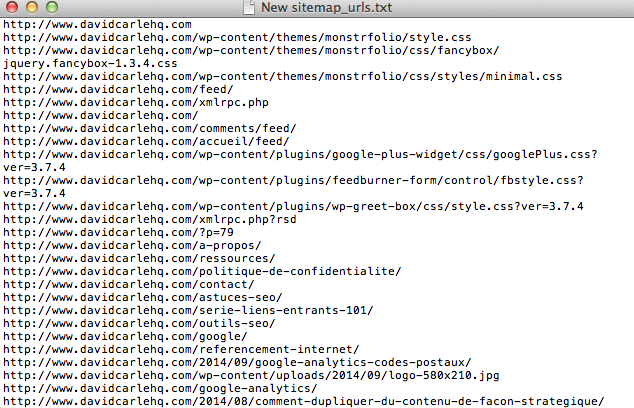

La première étape est de compiler une liste à jour des URL de votre site, dans un format qui vous permettra de les exporter dans une colonne d’un fichier Excel. Vous pouvez employer la méthode que vous désirez, exemple en utilisant votre sitemap, outil de votre choix tel que Screaming Frog, ou même, si le coeur vous en dit, de taper les URL à la main :-)

Ensuite, on exporte les URL en format .txt

Ensuite, on exporte la liste des URL dans un fichier Excel, soit la colonne A, pour être exact.

Liste d’URL en main, ou du moins sous la souris, on est maintenant prêt à passer à la deuxième étape de notre opération.

Étape 2 : Interroger Google sur les URL indexées de votre site

Dans un monde idéal, chacune des URL que nous avons exportées en phase 1 seraient indexées par Google. Maintenant nous savons que c’est rarement le cas, et curieux comme nous le sommes, désirons vérifier si Google indexe la plupart de nos URL.

En premier lieu, nous devons télécharger un rapide bookmarklet (un programme JavaScript exécutable d’un seul clic), nommé Google Serp Scrapper et développé par Cognitive SEO, qui nous permettra de “scrapper” les résultats de Google.

Donc, simplement prendre le fichier ici-bas et le glisser tout jusqu’à votre barre d’outils :

Google SERP Scraper – Déplacer le lien dans votre barre d’outils.

Le fichier sera donc accessible directement depuis votre barre d’outils.

Cela fait, on accède à Google.com, sous lequel nous allons maintenant changer les préférences de recherche.

Ce que nous désirons faire est de changer le nombre de résultats par page, de 10 résultats à 100 :

Une fois le changement complété, on retourne sur Google, et on lance une recherche avec la syntaxe suivante : site:www.monsite.com , où vous remplacer monsite.com par votre domaine. Pour ceux qui sont moins familiers avec les commandes Google, la syntaxe site: vous sortira tout les URL que Google possède dans son index à propos du site accompagnant la syntaxe.

Si vous avez bien suivi les opérations, vous avez devant vous une liste de maximum 100 résultats, soient 100 pages différentes indexées par Google. Bien sûr, si votre site compte moins de 100 pages, vous aurez un résultat inférieur en nombre de pages ;-)

Votre recherche effectuée, on clique sur le bookmarklet Google Serp Scrapper, et boom! On obtient une liste des résultats de Google dans une jolie fenêtre visant à favoriser l’exportation. On copie les URL, et on vient copier cette nouvelle liste dans la colonne B de notre document Excel créé en première étape.

Première note: Il n’est pas toujours simple de copier directement du fichier Google Serp Scrapper; vous aurez peut-être à supprimer manuellement la colonne des titres de pages.

Deuxième note : On répète l’expérience pour le nombre de pages de Google contenant 100 résultats. Exemple si Google détient 400 URL indexées de votre site, on exporte l’une après l’autre les 4 pages contenant les 400 URL différentes.

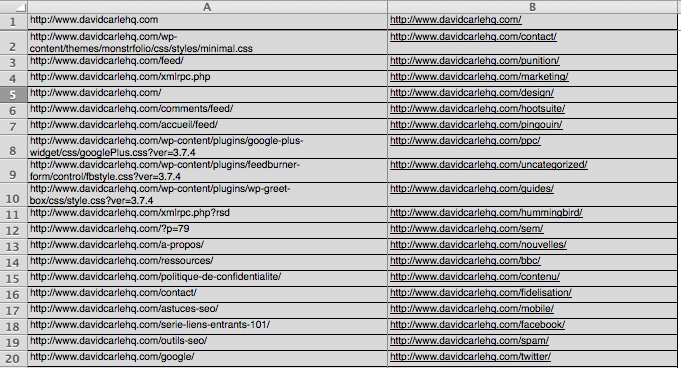

Au final, vous avez le résultat suivant : un fichier Excel avec deux colonnes, soient :

A) La colonne de la liste complète des URL de votre site, générée avec l’outil de votre choix.

B) La colonne des URL de votre site indexées par Google, importées avec notre bookmarklet “Google Serp Scrapper”.

Êtes-vous toujours là ? :-) La partie plus technique est maintenant chose du passé. Nous arrivons maintenant à l’objectif même de notre démarche, soit identifié les pages qui ne sont pas indexées par Google.

Étape 3 : Comparer les deux colonnes pour repérer les URL manquantes

Finalement, nous sommes à la dernière étape, qui rassurez-vous, sera moins compliqué que les deux précédentes.

Si vous avez bien suivi jusqu’à maintenant, vous devriez avoir un fichier Excel désordonné ressemblant à ceci :

En effet, tout ce que nous avons à faire maintenant est de mettre en ordre alphabétique les colonnes A et B de nos documents. Vous aurez compris que notre objectif est simplement d’aligner les deux séries d’URL sous les mêmes paramètres, par exemple en ordre alphabétique.

Donc, on compare les URL, et on remarque très facilement si des URL sont manquantes, lorsqu’elles apparaissent uniquement dans la colonne A, et non dans la colonne B.

Lorsque l’on déniche des URL manquantes, on peut maintenant passer à une analyse plus poussée, en étudiant la page à un niveau individuel. Est-ce que la page comporte du contenu unique ? Est-ce que les balises sont en faute ? Puis-je améliorer le placement de cette page dans la navigation de mon site ?

En espérant que cette astuce vous aidera à repérer tout problème d’indexation avec les URL de votre site :-)

P.S. : Je reconnais que cette astuce sera plus complexe pour certains d’entre vous, donc je porterai une attention très particulière aux questions qui seront soumises à travers les commentaires ici-bas.