En guise d’introduction à cet article, retournons légèrement dans le passé. En décembre 2013, une étude réalisée par l’entreprise Incapsula fait couler beaucoup d’encre en ligne, notamment à cause des statistiques chocs qu’elle révèle : en effet, il apparaît que plus de 60% du trafic Internet est automatisé : Logiciels de surveillance, robots d’indexations, outils de piratages et de spam, bref, l’être humain est maintenant devenu une denrée rare lorsqu’on parle de visiteurs en ligne.

Si cette étude souligne l’importance d’être prudent dans ses activités en ligne ainsi qu’au niveau de l’étanchéité de son site Internet, une autre interrogation vient troubler la quiétude du stratège SEO : si 31% du trafic Internet provient des robots d’indexation, est-ce que cela signifie que les statistiques de mon site Internet, exemple à travers Google Analytics, incluent les mêmes visites de ces fameux robots ?

Cette question ne se posait pas jusqu’à maintenant, puisque presque depuis les débuts du web, les robots d’indexation n’ont jamais été capables d’exécuter un code programmé en JavaScript, par exemple celui qui permet de lancer Google Analytics. Cependant, on sait que les moteurs font d’énormes progrès en ce sens, même que Google annonce publiquement que son robot d’indexation peut même comprendre les fichiers JS les plus simples. Matt Cutts mentionne d’ailleurs que Googlebot est maintenant très habile pour lire et comprendre les codes JavaScript. Cependant, on sent que ces deux énoncés sont faits en quelque sorte du bout des lèvres, sans que Google veuille statuer officiellement, probablement pour garder le mystère sur le fonctionnement de son puissant robot.

Dans cet article, nous regarderons ensemble comment nous pouvons segmenter le trafic associé aux robots d’indexation dans Google Analytics, et finalement, comment bloquer ces visites dans l’optique de purifier vos statistiques.

Une mesure inexacte

Google Analytics, a la réputation d’être un logiciel de mesure tout de même assez fiable, sans être parfait. Puisqu’il s’agit d’un outil sur lequel de nombreuses décisions importantes sont prises, par exemple au niveau de votre stratégie d’affaires, il est donc important de veiller à ce que vos statistiques soient le pus fiable possible.

Dans le cas des robots d’indexation, il n’est pas facile de les repérer dans Google Analytics. Premièrement, tel que mentionné en introduction, la plupart des robots ne peuvent pas interpréter le JavaScript, donc sont incapables d’exécuter le code JS requis par Google Analytics.

Cependant, lorsque l’on creuse dans les statistiques du logiciel de mesure, on se rend compte que certaines visites peuvent, en toute logique, être associées à des robots d’indexation. Par exemple, les statistiques des navigateurs/fureteurs utilisés par les visiteurs.

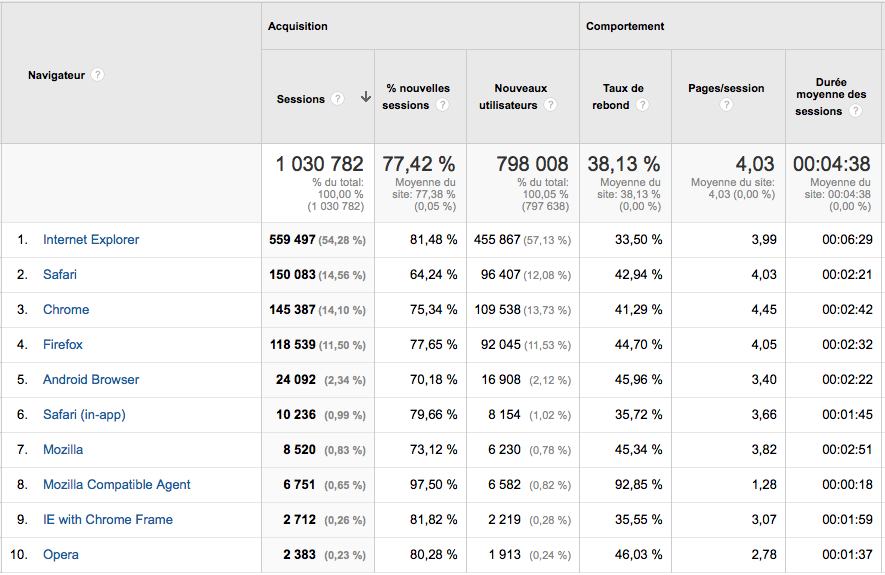

En accédant aux données des navigateurs (Audience/Technologie/Navigateur), on remarque qu’une ligne sort du lot, au niveau de son comportement.

Pouvez-vous dire lequel ?

Ceux qui ont répondu le #8 “Mozilla Compatible Agent” ont bien vu. Deux statistiques sautent aux yeux :

1) Le haut pourcentage de nouveaux visiteurs, soit 97,50%.

2) Le très élevé taux de rebond à 92,85%.

Ces deux données sont tellement plus élevées que la moyenne du site que cela ne peut que susciter des doutes sur la validité de ces visiteurs. Ajouter à cela que le terme “Mozilla Compatible Agent” semble indiquer une mauvaise compréhension du type de visiteur par Google Analytics et nous avons un joli mystère sur les bras :-)

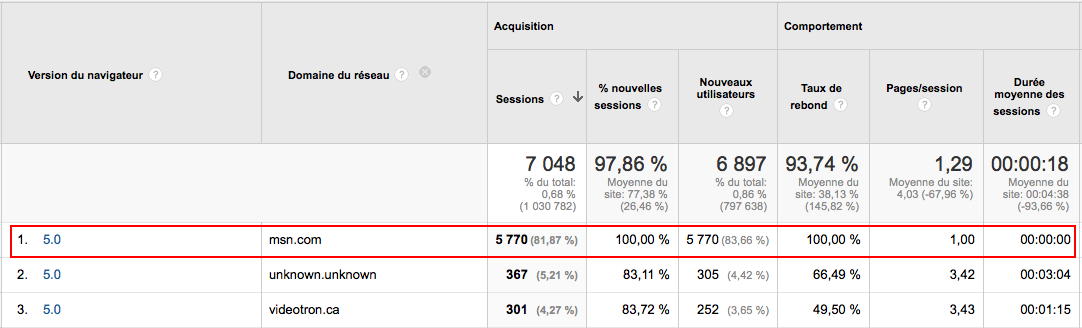

En sélectionnant “Mozilla Compatible Agent” et en activant la dimension “domaine du réseau”, j’obtiens une partie de ma réponse :

Ainsi, la forte majorité de ces visiteurs semblent provenir de msn.com. De plus, ces 5770 visiteurs ont un taux de rebond à 100%, et ont passé 0,00min sur le site, deux statistiques presque impossibles, à part si vous ciblez une clientèle de robot sur votre site :-)

De plus, tous ces mêmes visiteurs ont la même résolution d’écran, le même système d’opération… cela commence à faire beaucoup de coïncidences.

Évidemment, nous nageons en pleine supposition, puisque les moteurs de recherche sont généralement avares de commentaires à ce sujet. Est-ce qu’il s’agit d’un robot d’indexation associé à Bing ? Cela peut également être une attaque de “bots” pour faire planter un site, mais j’ai plutôt tendance à penser que la première réponse est la bonne.

Si nous avons possiblement démasqué le robot de Microsoft, qu’en est-il de Google ? Est-ce que le fameux Googlebot se cache également parmi les statistiques de Google Analytics ?

Cette fois-ci, au lieu du rapport sur les navigateurs, accédons à celui sur les “réseaux” (Audience/Réseaux), et cherchons pour “Google”, pour le plaisir :

Et bien, on note passablement moins de visites de Google Inc. que de Microsoft. On note cependant les mêmes données suspectes : taux de rebond 2.5 fois la moyenne du site, 100% nouvelles visites, 0:00:00 temps passé sur le site.

On ne peut être évidemment certain si s’agit de robot d’indexation, ou plutôt d’une mauvaise interprétation par Google Analytics de certains visiteurs malchanceux. Ce qui est plutôt clair, en revanche, est que ces visites en apparence très louches nuisent aux statistiques de votre site, en impactant les données d’engagement.

Nous voulons tous que nos données analytiques soient les plus “propres possible”. Alors, comment faire pour les retirer de vos données Google Analytics ?

Bloquer les robots et visiteurs artificiels

Deux méthodes sont recommandées pour filtrer les statistiques des robots d’indexation.

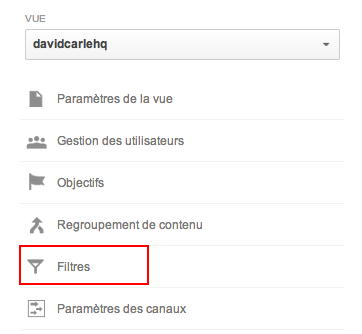

1- Créer un filtre d’exclusion : Les filtres sont l’une des plus puissantes fonctionnalités de Google Analytics. On se sert de ceux-ci pour exclure la catégorie de trafic de son choix, afin de filtrer celle-ci des données principales.

Les filtres sont accessibles à partir du menu “Admin” et ensuite “Filtres”.

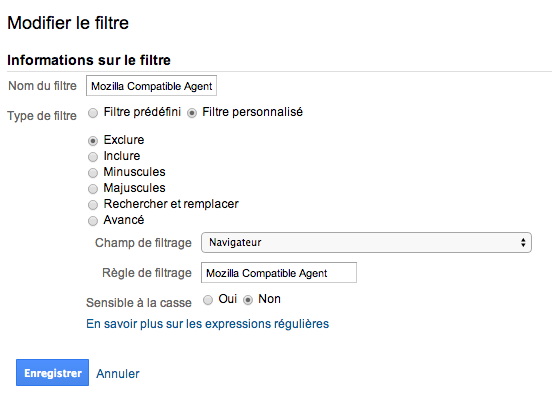

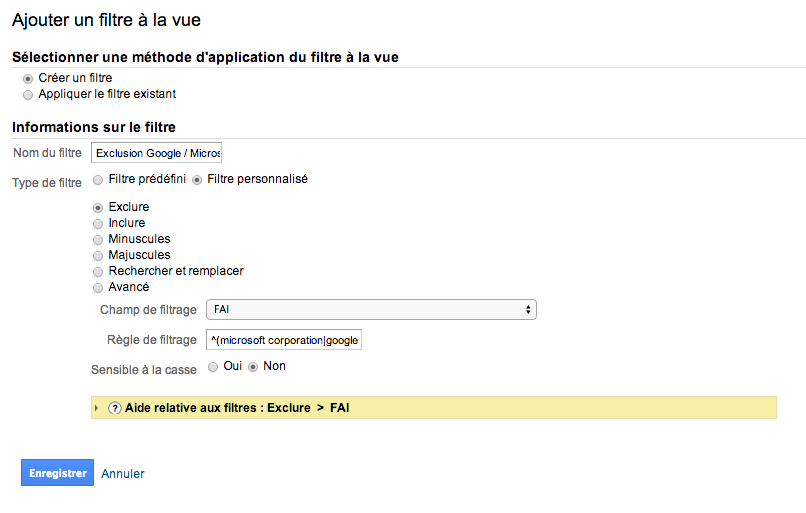

Dans filtres, on sélectionne le type de filtre “personnalisé”, et on vient tout simplement exclure le trafic appartenant au navigateur “Mozilla Compatible Agent” :

Pour Google, on créer un nouveau filtre tel qu’ici haut, cependant on change le champ de filtrage pour “Domaine du réseau”. Si vous êtes à l’aise avec le regex, on peut même faire une pierre d’un coup en configurant une règle qui exclura à la fois Microsoft et Google, en choisissant un filtre qui exclura les organisations ici haut , avec le regex suivant :

^(microsoft corporation|google inc\.)

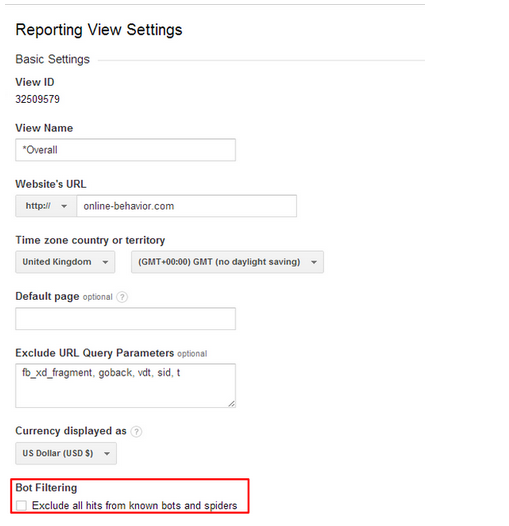

2- Utiliser la nouvelle fonction de Google Analytics

Deuxième possibilité, Google Analytics a récemment ajouté une nouvelle fonctionnalité où on peut simplement désactiver le suivi des bots et visiteur artificiel dans Google Analytics.

Cette fonctionnalité est récente, et encore très peu testée. De plus, on ignore ce que Google Analytics exclura comme visites. Vous pouvez l’essayer, et ensuite analyser si les visites artificielles semblent être enlevées, et dans le pire des cas, utiliser le filtre de la première option.

En espérant que vous avez apprécié cette astuce Google Analytics. Bonne analyse !